San José (Californie, États-Unis) — GTC — Le 25 mars 2014

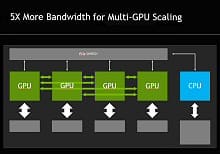

La société NVIDIA a aujourd’hui annoncé qu’elle prévoit d’intégrer une interconnexion haut débit, appelée NVIDIA NVLink, à ses futurs GPUs, afin de permettre aux CPUs et aux GPUs d’échanger des données cinq à douze fois plus rapidement qu’à l’heure actuelle. Ceci éliminera un goulot d’étranglement de longue date et aidera à ouvrir la voie à une nouvelle génération de supercalculateurs exaflopiques, qui sont 50 à 100 fois plus rapides que les systèmes les puissants disponibles aujourd’hui.

NVIDIA intégrera la technologie NVLink à son architecture GPU Pascal, qui devrait être lancée en 2016, faisant suite à la nouvelle architecture Maxwell présentée cette année. La nouvelle interconnexion a été développée conjointement avec IBM, qui l’ajoute actuellement aux futures versions de ses CPUs POWER.

« La technologie NVLink libère tout le potentiel des GPUs en améliorant de façon spectaculaire le transfert de données entre le CPU et le GPU, réduisant ainsi le temps pendant lequel le GPU doit attendre pour que les données soient traitées », a expliqué Brian Kelleher, Vice-président senior de l’ingénierie GPU chez NVIDIA.

« NVLink permet des échanges de données rapides entre CPU et GPU, améliorant ainsi le débit de données des systèmes informatiques et supprimant l’un des principaux obstacles actuels aux calculs intensifs, a ajouté Bradley McCredie, Vice-président chez IBM et IBM Fellow. NVLink facilite pour les développeurs la modification des applications d’analyse de données et de haute performance, afin de tirer profit des systèmes hybrides CPU-GPU. Nous estimons que cette technologie représente une nouvelle contribution importante à notre écosystème OpenPOWER. »

Avec la technologie NVLink associant étroitement les CPU POWER d’IBM et les GPU Tesla de NVIDIA, l’écosystème de centres de données POWER sera en mesure d’exploiter pleinement l’accélération GPU dans toute une palette d’applications, comme le calcul intensif, l’analyse de données ou l’apprentissage automatique.

Avantages par rapport au PCI Express 3.0

Les GPUs actuels sont connectés à des CPUs x86 par le biais de l’interface PCI Express (PCIe), ce qui limite la capacité du GPU à accéder à la mémoire CPU et est quatre à cinq fois plus lent que les interfaces mémoire CPU classiques. L’interface PCIe constitue un goulot d’étranglement encore plus important entre le GPU et les CPUs POWER d’IBM, qui offrent plus de bande passante que les CPUs x86. Puisque l’interface NVLink correspondra à la bande passante mémoire CPU classique, elle permettra aux GPUs d’accéder à la mémoire CPU avec la même bande passante.

Cette interconnexion haut débit améliorera considérablement les performances des applications de calcul intensif. En raison des différences entre les systèmes de mémoire (les GPUs possèdent des mémoires rapides mais petites, tandis celles des CPUs sont grandes mais lentes), les applications de calcul intensif transfèrent généralement les données du réseau ou du stockage sur disque vers la mémoire du CPU, puis copient les données sur la mémoire du GPU, avant qu’elles puissent être traitées par celui-ci. Avec NVLink, les données circulent entre la mémoire CPU et celle du GPU à des vitesses nettement plus grandes, permettant aux applications accélérées par GPU (GPU) de fonctionner beaucoup plus vite.

Une Mémoire unifiée

La vitesse accrue des transferts de données, associée à une autre fonctionnalité appelée Mémoire unifiée, simplifiera la programmation des accélérateurs GPU. La Mémoire unifiée permet au programmeur de traiter les mémoires du CPU et du GPU comme un seul bloc de mémoire. Le programmeur peut intervenir sur les données, sans avoir à se soucier de savoir si elles se trouvent dans la mémoire CPU ou celle du GPU.

Même si les futurs GPUs de NVIDIA continueront à fonctionner sous PCIe, la technologie NVLink sera utilisée pour connecter les GPUs aux CPUs compatibles avec NVLink, ainsi que pour fournir des connexions haut débit directement entre plusieurs GPUs. De plus, malgré son très haut débit, NVLink consomme nettement moins d’énergie par bit transféré que le PCIe.

NVIDIA a conçu un module destiné à héberger les GPUs s’appuyant sur l’architecture Pascal avec NVLink. Ce nouveau module GPU ne représente qu’un tiers de la taille des cartes PCIe standard utilisées à l’heure actuelle pour les GPUs. Des connecteurs au bas du module Pascal permettent de le brancher à la carte mère, améliorant la conception du système et l’intégrité du signal.

L’interconnexion haut débit NVLink activera les systèmes à configuration hybride qui représentent une avancée vers des supercalculateurs exaflopiques très économes en énergie et évolutifs, fonctionnant à 1 000 pétaflops (1 x 1018 opérations en virgule flottante par seconde), soit 50 à 100 fois plus vite que les systèmes les plus rapides disponibles actuellement.

Plus sur NVIDIA : www.nvidia.fr